INFORMACIÓN Y TECNOLOGÍA

En Septiembre de 2007, los monjes budistas de Birmania abandonaron sus tranquilos monasterios para encabezar manifestaciones pacíficas en defensa de la democracia.

Con los medios de comunicación controlados por una junta militar, en el poder desde 1962, Internet fue la clave para dar a conocer al mundo la situación en el país del sudeste asiático. Las protestas fueron reprimidas con violencias: llegaron a morir decenas de personas.

Las imágenes de las manifestaciones burlaron la censura y se enviaron por correo electrónico, los testimonios de la represión se difundieron en los blogs y en YouTube se pudo ver la opulenta vida de los generales birmanos en uno de los países con mayor pobreza y corrupción.

Los militares respondieron cortando el acceso a la Red durante una semana, pero no pudieron impedir que las noticias corrieran ya por el ciberespacio como la pólvora.

Miles de manifestaciones, coordinados en ciudades de los cinco continentes, exigían a sus gobiernos una reacción.

Los activistas se habían auto organizado en Internet por medio de Facebook, una red social de contactos que fue creada originalmente para hacer amigos en la universidad.

A un canadiense de 19 años, que había viajado ese verano por Birmania, se le ocurrió usar ese mismo sistema para iniciar una campaña política. En pocos días tenía a 300.000 personas apoyándole: era la envidia de cualquier ONG.

Ante esta movilización global, algunos líderes de las principales potencias respondieron prometiendo sanciones contra la dictadura Birmania.

Internet ya no es solo un sitio donde acceder gratis a información de todo tipo y descubrir qué está pasando en cualquier país, sino que permite a cualquier ciudadano intervenir en la política internacional.

Una misma persona puede redactar y también corregir la mayor enciclopedia del mundo, comprar libros y antigüedades en una subasta internacional, colaborar en la investigación de una cura para el sida, difundir sus propias noticias por todo el planeta, descubrir y promocionar nuevos talentos musicales o, simplemente, divertirse o compartir sus vivencias con la familia y los amigos aunque estén lejos. Todas esas cosas, inaccesibles en solitario, son posibles cuando los individuos se conectan entre sí con sus ordenadores, consolas y dispositivos móviles.

Esas multitudes interconectadas comparten tanto información como recursos y forman redes y comunidades. Todo ello gracias a unas armas de colaboración masiva: las tecnologías de la información.

INTERNET: NACIDA PARA COMPARTIR

Es difícil imaginarse el mundo sin Internet, pero ¿puede estropearse la Red?

¿Qué es una red?

El término genérico "red" hace referencia a un

conjunto de entidades (objetos, personas, etc.) conectadas entre sí.

Por lo tanto, una red permite que circulen elementos materiales o

inmateriales entre estas entidades, según reglas bien definidas.

- red: Conjunto de equipos y dispositivos periféricos conectados entre sí. Se debe tener en cuenta que la red más pequeña posible está conformada por dos equipos conectados.

En 2002 sufrimos varios apagones regionales en España durante unas horas y en Estados Unidos falló por un día uno de los mayores proveedores mundiales, WorldCom. Ese día muchos mensajes de correo electrónico llegaron con retraso, algunos incluso se perdieron y se ralentizó el tráfico por todo el ciberespacio.

Sin embargo, Internet fue diseñada a prueba de fallos: no existe una central en la que se pueda producir una avería que a su vez provoque un apagón mundial. Es como una red de pesca en la que los ordenadores son los nudos: la información logrará encontrar un camino entre dos nudos, aunque haya agujeros en medio. Una red así parece invulnerable. Y en plena Guerra Fría, eso entusiasmó a los jefes militares de Estados Unidos que pusieron en marcha Arpanet, la procesadora de Internet.

Conocemos al concepto de ARPANET como una de las redes creadas por encargo del Departamento de Defensa de los Estados Unidos para poder establecer un importante nexo de comunicación entre los distintos Organismos Gubernamentales de la nación.

Se ha dicho que el proyecto nació como un sistema militar residente en una eventual ataque nuclear de los soviéticos.

Pero, en realidad, el Departamento de Defensa estadounidense financió Arpanet para que las universidades de ese país pudieran compartir sus ordenadores, conectándolos entre sí aunque fueran de distintos fabricantes y funcionaran de manera muy diferente. Así, en 1969 la comunidad científica de Estados Unidos empezó a compartir datos, novedades sobre sus investigaciones y mensajes personales.

Ciberespacio

Ciberespacio suele usarse como sinónimo de Internet, pero no se refiere a la red de comunicaciones en sí, sino al mundo virtual en el que existen las páginas web. Así pues, más que un complejo objeto como el que muestra la fotografía es una metáfora mejor representada en la ilusión visual: el triángulo blanco que no existe en ninguna parte pero une entre sí ordenadores de todo el planeta.

Ciberespacio

Conjunto o realidad virtual donde se agrupan usuarios, páginas web, chats, y demás servicios de Internet y otras redes. El término fue utilizado por primera vez por William Gibson, escritor norteamericano en su novela de ciencia ficción "Neuromante" publicada en 1984.

Paquetes de información

Ahí se acaba cualquier parecido con el correo tradicional. En el buzón virtual del remitente el mensaje se divide en partes que viajan por rutas diferentes, por cualquiera de los caminos posibles de esa red global, hasta llegar al buzón del destinatario. Es aquí donde se reúnen los trozos del mensaje y se recompone la postal electrónica.

En Internet la información siempre viaja troceada en pequeños paquetes de un máximo de 1500 bytes (que equivalen a 250 palabras de texto, una décima de segundo de música en MP3).

De esta manera, cuando se produce un mínimo corte o interferencia se reenvían de forma automática solo los paquetes extraviados y no hay que repetir la transmisión paquetes extraviados y no hay que repetir la transmisión entera, como sucede al mandar una página de fax por línea telefónica.

En su ruta, cada paquete puede pasar por cientos de ordenadores intermediarios, del mismo país o de otros; y funcionan con Windows, con Mac OS, con Linux o bien con cualquier otro sistema operativo.

En la Red todos hablan el mismo idioma, una especie de esperanto informático: el TCP/IP.

El TCP/IP

El TCP/IP es el conjunto d protocolos que comenzó a usarse en 1983 para dirigir el tráfico de los paquetes de información por Arpanet y garantizar que todos llegan a su destino.

¿Que es el TCP/IP? - Definición de TCP/IP

TCP/IP son las siglas de Protocolo de Control de Transmisión/Protocolo de Internet (en inglés Transmission Control Protocol/Internet Protocol), un sistema de protocolos que hacen posibles servicios Telnet, FTP, E-mail, y otros entre ordenadores que no pertenecen a la misma red.El Protocolo de Control de Transmisión (TCP) permite a dos anfitriones establecer una conexión e intercambiar datos. El TCP garantiza la entrega de datos, es decir, que los datos no se pierdan durante la transmisión y también garantiza que los paquetes sean entregados en el mismo orden en el cual fueron enviados.

El Protocolo de Internet (IP) utiliza direcciones que son series de cuatro números ocetetos (byte) con un formato de punto decimal, por ejemplo: 69.5.163.59

Así nació la actual Internet. Redes de uno y otro país, redes públicas y privadas, redes de alta velocidad con cables de fibra óptica, redes más modestas por vía telefónica, redes inalámbricas...., todas se sumaron a la red original.

La aportación europea fueron las páginas web, creadas en 1991, que popularizaron la Red. Más de 1300 millones de personas (uno de cada cinco habitantes del planeta) estaban conectados en 2008. Y cada día son más.

El reto no solo es aumentar ese número, sino también el porcentaje de conexiones de banda ancha (alta velocidad y acceso permanente) que es necesario para realizar el envío de archivos muy pesados y para disponer de servicios como la videoconferencia.

SÍMBOLOS Y DIRECCIONES DE INTERNET

La historia de la @

La arroba (@) es un símbolo utilizado en las direcciones de correo electrónico para separar el nombre del usuario del nombre del dominio, ambos necesarios para transmitir los emails. Por ejemplo, la dirección de email administrador@masadelante.com indica que el usuario administrador recibe correo electrónico "en" el dominio masadelante.com.

El símbolo arroba tiene distintos nombres segun el país. En inglés la arroba es conocida como el símbolo "at" (en), y otros países tienen otros nombres, muchos de estos países asocian el símbolo a nombres de alimentos o animales, por ejemplo, en Afrikaans se llama aapsert, que significa cola de mono y en croata I loca.

Además de en las direcciones de correo electrónico, esa <@> con melena peinada hacia atrás se usa como símbolo de modernidad. Sin embargo, la arroba ya navegaba hace cinco siglos en los barcos de los mercaderes venecianos. En una carta mercantil de 1536 aparece como abreviatura del ánfora, una antigua unidad de peso y capacidad usada en el comercio por el Mediterráneo.

Tanto griegos como romanos usaban el ánfora, un cántaro alargado de cerámica, con una capacidad de 26,2 Litros.

Los comerciantes anglosajones la utilizaban desde el siglo XIX con el significado de <al precio de>. En sus libros de contabilidad anotaban cosas como <2 sillas @ 4 dólares>. Por eso el símbolo ya estaba en los teclados de las máquinas de escribir antes de que existiese internet.

La arroba saltó a la fama por casualidad en 1972. El ingeniero estadounidense Ray Tomlison diseñaba un sistema de correo electrónico para Arpanet y necesitaba un separador dentro de las direcciones. Tenía que ser un carácter que nadie usara en su nombre de usuario. Letras y números quedaban descartados. Tomlison bajó los ojos hacia el teclado y eligió ese como podía haber elegido otro.

En inglés @ se lee at, así, ray@gmail.com significa <ray en gmail.com>

Direcciones IP, la matrícula de los ordenadores

En internet cada ordenador se identifica por una dirección IP (Internet Protocol), del tipo 188.40.234.3. Esos cuatro números separados por puntos pueden tener valores desde el 0 hasta el 255. Con este sistema IPv4 los posibles direcciones solo 256: casi 4300 millones, ni siquiera una por persona. Los creadores de Internet no imaginaron que todo el mundo querría conectarse.

El actual sistema se agotará, como ocurre con el de las matrículas de los coches. Hoy se trabaja en la versión 6 del protocolo IP, con 3,4 x 10 posibles direcciones del tipo 2001: 0db8:85a3:1319:8a2e:0370:7334. Eso da unas 5000 por cada mm de superficie terrestre. Parece más que suficiente, incluso para un futuro en el que cada ordenador, teléfono móvil, iPod y coche estén conectados a Internet y tengan su propia dirección. Sin embargo, la transición al IPv6 es un reto tecnológico aún por resolver.

Cada vez que te conectas a Internet, lo habitual es que tu proveedor te asigne una dirección IP distinta, que además puede cambiar en pocas horas. Esta dirección de IP es una IP dinámica. Para tener una IP fija hay que pagar algo más.

Una dirección IP es un número que identifica de manera lógica y jerárquica a una interfaz de un dispositivo (habitualmente una computadora) dentro de una red que utilice el protocolo IP (Internet Protocol), que corresponde al nivel de red o nivel 3 del modelo de referencia OSI.

Es habitual que un usuario que se conecta desde su hogar a Internet utilice una dirección IP. Esta dirección puede cambiar al reconectar; y a esta forma de asignación de dirección IP se denomina una dirección IP dinámica (normalmente se abrevia como IP dinámica).

DNS, navegamos como un intérprete

Los ordenadores se comunican en Internet mediante su direcciones IP, pero las personas necesitamos unas direcciones más fáciles de recordar que esas secuencias de números.

Los servidores de nombres de dominio (DNS) hacen de intérpretes entre usuarios y ordenadores.

Cuando escribimos una dirección, por ejemplo la del Ministerio de Educación y Ciencia, www.mec.es, el DNS la traduce a la dirección IP del servidor donde está alojada la página web que queremos visitar.

DNS es una

abreviatura para Sistema de Nombres de Dominio (Domain Name System), un sistema

para asignar nombres a equipos y servicios de red que se organizan en una

jerarquía de dominios. La asignación de nombres DNS se utiliza en las redes

TCP/IP, como Internet, para localizar equipos y servicios con nombres sencillos.

Cuando un usuario escribe un nombre DNS en una aplicación, los servicios DNS

podrán traducir el nombre a otra información asociada con el mismo, como una

dirección IP.

No cabe duda

que un nombre sencillo resulta más fácil de aprender y recordar, pero los

equipos se comunican a través de una red mediante direcciones numéricas; para

facilitar el uso de los recursos de red, los servicios de nombres como DNS

proporcionan una forma de asignar estos nombres sencillos de los equipos o

servicios, a sus direcciones numéricas.

¿Cuántas IP te sabes de memoria?

Ninguna.

¿Cuántos número de teléfonos?

Número de teléfonos unos 5 ó 6 aproximadamente.

CONEXIONES Y VELOCIDAD DE ACCESO A INTERNET

Los cables de fibra óptica han adelantado a los de cobre en las autopistas de la información.

Formados por cientos de finísimas hebras de vidrio o plástico, estos claves permiten enviar muchos datos a gran velocidad. La información viaja a través de ellos en haces de luz que rebotan en las paredes de la fibra: gracias a la reflexión total interna de este material, la luz recorre grandes distancias sin interferencias electromagnéticas.

Pero las fibras son muy frágiles y es bastante difícil empalmar los cables.

Por este motivo, aunque es esqueleto de Internet sea de fibra óptica, a los hogares la conexión llega por otras vías.

Tipos de conexiones

Línea telefónica. Está pensada para transmitir información analógica (voz), por eso es necesario utilizar un módem (modulador-demodulador), que convierte la información digital en pitidos de dos tonos (ceros y unos).

Su velocidad máxima de descarga es de 56600 bps (bits por segundo).

Cable. Los proveedores de cable tienden redes de fibra óptica bajo las calles, pero a las casas la conexión llega por un cable coaxial de cobre, similar al de la antena de televisión, que se conecta al módem de cable.

Está tecnología solo llega a núcleos de población importantes.

Es la conexión más rápida: hasta 30 Mbps (megabits por segundo).

ADSL. Mediante la utilización de las líneas telefónicas de cobre es posible un acceso de banda ancha que además permite hablar por teléfono al mismo tiempo.

Se necesita un módem especial y adaptar la centralita telefónica.

La velocidad máxima oscila 8 Mbps y 24 Mbps.

Satélite. Existen diferentes sistemas. Unos reciben la información por antena parabólica y la envían a través de una línea telefónica, pero lo ideal es un servicio bidireccional que envía y recibe directamente al satélite.

En España es la conexión más cara y su velocidad máxima es de 2Mbps.

Telefonía móvil. La tecnología de tercera generación (3G) ofrece conexión de banda ancha para los teléfonos móviles y también para los ordenadores, ya sea mediante un módem 3G o a través de un teléfono.

De momento la cobertura no llega a todo el país.

Velocidad máxima: 7,2 Mbps.

Wifi, compartir la conexión

Con independencia del tipo de conexión que se haya solicitado al proveedor de Internet, dentro de casa el módem o router que contiene tecnología Wifi crea una red que permite conectar varios ordenadores sin cables desde cualquier habitación.

Pero lo que los internautas demandan cada vez más es tener acceso inalámbrico en cualquier punto de la ciudad.

Existen ya muchos puntos de acceso Wifi (hotspots) en lugares públicos como bibliotecas, cafeterías, aeropuertos, hoteles, etc.., que pueden ser abiertos y gratuitos, de pago o restringidos a clientes.

Otra alternativa es unirse a una comunidad Wifi y compartir la conexión con otras personas. Así tendrás acceso gratuito cerca de la casa de cualquier miembro de tu comunidad.

Su comodidad ha hecho que las redes inalámbricas hayan proliferado tanto que ya se habla de contaminación Wifi.

Demasiados puntos de acceso en su vecindario crean interferencias y saturan una banda de frecuencias (2,4 GHz) a la que también operan los hornos microondas y los móviles con Bluetooth.

Uno de los principales defectos atribuidos a la conectividad WiFi es su poca seguridad. Existen, sin embargo, diversos protocolos de cifrado que permiten codificar la transmisión de los datos y garantizar su confidencialidad.

Hotspots

Puntos de acceso Wifi en lugares públicos como bibliotecas, cafeterías , aeropuertos, hoteles ...

Navegador Web : momentos estelares de la historia.

El 13 de octubre de 1994, se lanzó la

primera versión de Netscape, primer navegador web al alcance del gran

público.El programador británico Tim Berners-Lee ideó un sistema

sencillo para que todos los científicos de todo el mundo pudieran

compartir los resultados de sus investigaciones World Wide Web(www).

Su idea fue usar enlaces de hipertextos para saltar de una página a

otra, en ellas solo se podía ver texto, las imágenes, habían que

cargarlas apartes.

Hipertexto : Es el texto que contiene elementos ( enlaces ) que permiten acceder a otra información.

Mosaic: Surgió en 1993,primer navegador web con interfaz gráfica (con una barra para poder teclear las direcciones y los botones para avanzar retroceder y recargar páginas) disponible para Windows, Mac, y Unix.

Entre los pioneros de la web, algunos temían que las páginas multimedia

que se veían con Mosaic atrajeran a multitud de usuarios que estos

colgaran fotos de todo tipo, usaran molestos sonidos de fondo y

distribuyeran videos de tan poco interés científico como los primeros

pasos de sus hijos.

Aquellos visionarios acertaron de nuevo. Cuanta más gente probaba el navegador, más contenidos se creaban, y eso atraía a nuevos usuarios a la web (uno de los muchos servicios de Internet), que también usaban Mosaic. El número de sitios web comenzó a experimentar un crecimiento exponencial, se duplicaba cada tres meses.

Visto el éxito en el mundo científico, al acabar sus estudios, Marc Andreessen fue reclutado por un empresario de Silicon Valley donde fundaron Netscape, con el que la revolución llegó a los hogares a finales de 1994.

Aquel navegador era más fácil de usar y tenía mejoras importantes sobre Mosaic.

Aquellos visionarios acertaron de nuevo. Cuanta más gente probaba el navegador, más contenidos se creaban, y eso atraía a nuevos usuarios a la web (uno de los muchos servicios de Internet), que también usaban Mosaic. El número de sitios web comenzó a experimentar un crecimiento exponencial, se duplicaba cada tres meses.

Visto el éxito en el mundo científico, al acabar sus estudios, Marc Andreessen fue reclutado por un empresario de Silicon Valley donde fundaron Netscape, con el que la revolución llegó a los hogares a finales de 1994.

Aquel navegador era más fácil de usar y tenía mejoras importantes sobre Mosaic.

Firefox, la reencarnación de Netscape

Firefox: Navegador mas avanzado en cuestiones de privacidad y seguridad.Es símbolo de la cultura del software libre es gratuito. El código de programación con el que está hecho Firefox está basado por Netscape, fue barrido por Internet Explorer. Los creadores de Firefox quisieron llamarlo Phoenix, como el pájaro mitológico que renace de sus cenizas. Pero la marca estaba registrada y el nombre definitivo es el de un animal en peligro de extinción.

Yahoo, los favoritos de todo el mundo

En 1994 dos estudiantes de la Universidad de Stanford (EEUU) publicaron una página con enlaces a sus sitios web favoritos: <<La guía de Jerry y David para la World Wide Web>>, que pronto cambiaron por un nombre con más gancho, Yahoo.

Fue el primer directorio de Internet y llegó a convertirse en la página de inicio de la mayoría de los internautas. Catalogaba las nuevas páginas en categorías y marcaba los mejores con un icono que representaba una gafas de sol.

Pero pronto esa tareas se convirtió en imposible. En 1997 se alcanzó el millón de sitios web: había empezado la era de los buscadores.

La manera inicial de navegar con directorios todavía es posible en http://es.dir.yahoo.com/

Un programa revolucionario

En la jerga informática se les conoce como Killer apps (aplicaciones asesinas). En español, aplicaciones bomba: es el software que hace explotar una tecnología, de manera que desarrolla sus posibilidades y multiplica las ventas del hardware que lo soporta.

Si Netscape fue la aplicación bomba de Internet, otros programas convirtieron en grandes éxitos al PC, el Macintosh, y la Gameboy:

- PC (1983). Las ventas del primer PC de IBM fueron

muy flojas hasta que salió al mercado una hoja de cálculo llamada Lotus

1-2-3, que lo convirtió en un best-seller en el mundo empresarial.

- Macintosh (1985). Aldus PageMaker fue el primer

programa de maquetación que mostraba las páginas tal cual en la pantalla

(WYSIWYG, what you see is what you get). Este programa hizo que el

Macintosh de Apple conquistara a los diseñadores gráficos.

- Gameboy (1989). El juego de Tetris se hizo muy popular desde su lanzamiento en 1985, pero hizo un dúo imbatible son la Gameboy. Este juego venía incluido en la consola portátil de Nintendo, que sedujo tanto a los niños como a los adultos deseosos de jugar al Tetris en cualquier lugar.

GOOGLE : EL ALGORITMO QUE LO BUSCA TODO .

Tiene un eslogan interno y resume en tres

palabras el código ético adoptado por los fundadores del principal

buscador de Internet para evitar que se les fuera de las manos.

Google fue un proyecto de investigación de dos estudiantes en 1996.Google es una compañía estadounidense fundada en septiembre de 1998 cuyo producto principal es un motor de búsqueda creado por Larry Page y Sergey Brin. El término suele utilizarse como sinónimo de este buscador, el más usado en el mundo.

La característica más destacada de Google como buscador es su facilidad de uso.

Larry y Sergey estudiantes de la Universidad de Stanford plantearon su hipótesis: una página es más importante cuanto más enlaces apunten hacia ella.

En la práctica, había que ir más allá, pues un enlace desde el New York

Times es más valioso que desde una página personal cualquiera. Así que

los primeros resultados de una búsqueda debían ser las páginas más

enlazadas desde otras páginas relevantes. Los detalles de cómo Google

determina eso están en un complejo algoritmo, que se puede definir como una secuencia de

instrucciones que representan un modelo de solución para determinado

tipo de problemas. O bien como un conjunto de instrucciones que

realizadas en orden conducen a obtener la solución de un problema. Por

lo tanto podemos decir que es un conjunto ordenado y finito de pasos que

nos permite solucionar un problema.

Los algoritmos son independientes de los lenguajes de programación. En cada problema el algoritmo puede escribirse y luego ejecutarse en un lenguaje de diferente programación. El algoritmo es la infraestructura de cualquier solución, escrita luego en cualquier lenguaje de programación.

Los algoritmos son independientes de los lenguajes de programación. En cada problema el algoritmo puede escribirse y luego ejecutarse en un lenguaje de diferente programación. El algoritmo es la infraestructura de cualquier solución, escrita luego en cualquier lenguaje de programación.

PageRank :

PageRank (PR) es un valor numérico que representa la popularidad que una página web tiene en Internet.

Cuando el algoritmo estuvo listo, Page y Brin trataron de vender su

motor de búsqueda. No tenían demasiado interés en montar su propia

empresa, pero los grandes portales de Internet tampoco tenían mucho

interés en mejorar sus buscadores. Así que siguieron por su cuenta, con

la ayuda de varios inversores que pusieron un millón de dólares, y de un

amigo que les alquiló su garaje.PageRank (PR) es un valor numérico que representa la popularidad que una página web tiene en Internet.

<<To Google>> aparece en los diccionarios de inglés como verbo que significa buscar en Internet, ya sea con ese o con otros, como Yahoo, MSN o Ask.com. El país más glooglero del mundo es España.

Silicon Valley es un estado de ánimo

Silicon Valley no aparece en Google Maps ni en ningún atlas. La meca de la innovación tecnológica no es un área geográfica ni un distrito administrativo.

En la actualidad se llama Silicon Valley a una zona del norte de California situada entre las ciudades de San Francisco y San José, aunque no hay un consenso sobre sus límites.

El término de Silicon Valley, acuñado en 1971 por un periodista, se debe a la alta concentración de empresas informáticas(que usan chips de silicio) en el norte del valle de Santa Clara.

Pero con el crecimiento de esa industria en la zona, impulsada desde la Universidad de Stanford, la localización geográfica ya no define Silicon Valley con tanta precisión como la actualidad de sus habitantes, emprendedora y abierta hacia las nuevas tecnologías.

Varias de sus grandes empresas fueron fundadas por estudiantes en un garaje, que servía al mismo tiempo de laboratorio y oficina:

- Hewlett-Packard: Palo Alto (1938)

- Apple: Los Altos (1976)

- Google: Menlo Park (1998)

Engañar a Google

El <<google bombing>> es una trampa para que una página aparezca en los primeros lugares al buscar una palabra determinada. Teniendo en cuenta cómo funciona Google, ¿cómo crees que se puede hacer?

Está técnica empezó a usarse en reivindicaciones sociales y políticas, como ocurrió, por ejemplo, en el caso de la crisis del vertido del petróleo Prestige en 2002: http://google.dirson.com/prestige.php

También se usa para desacreditar a personas o promocionar productos. En 2007 los ingenieros de Google incorporaron un pequeño algoritmo para minimizar el efecto de estas bombas.

LOS NAVEGANTES TEJEN LA RED

Blog. El boca a boca del ciberespacio

Esta nueva posibilidad surgió a finales de los años noventa gracias al blog (abreviatura del weblog) o bitácora.

El blog es un tipo de página web en la que uno o varios autores escriben de forma periódica sobre temas de su interés y donde los lectores pueden dejar sus comentarios.

Así se generan conversaciones y debates de los que surgen comunidades de personas con interés afines, muchas de ellas con su propio blog.

Otra particularidad de los blogs son los enlaces. Los artículos, además de texto e imágenes, suelen contener enlaces a otras páginas que llaman la atención del autor. De esta manera da a conocer esas páginas que es posible que otros también las enlacen desde sus blogs.

Los blogs tienen el poder de difundir y hacer relevante una información, aparezca o no en los periódicos.

Wikipedia. La sabiduría de las multitudes

Todo el mundo es un experto en algo. Con esta idea nació en 2001 la Wikipedia, una enciclopedia que permite cualquier usuario pueda añadir y modificar sus contenidos desde su navegador web.

La Wikipedia tiene pocos trabajadores a tiempo completo, y en ella colaboran millones de voluntarios de todo el mundo que se auto organizan para controlar la calidad de sus contenidos.

En 2007 la Wikipedia se convirtió en la décima web más visitada. Es el lugar más habitual para empezara informarse sobre un tema, aunque nunca debería ser el único.

Web 2.0: el espectador es el protagonista

En 2006 la conocida revista Time te nombró a ti, internauta, persona del año.

Este hecho se debió a que 2006 fue el año en el que las nuevas webs, creadas o mejoradas gracias a la colaboración de los propios usuarios (las que forman la llamada Web 2.0), empezaron a superar en visitas a las webs tradicionales: Wikipedia superó a la Britannica, Blogger superó a la CNN, Google Maps superó a MapQuest.

El término Web 2.0 comprende aquellos sitios web que facilitan el compartir información, la interoperabilidad, el diseño centrado en el usuario y la colaboración en la World Wide Web. Un sitio Web 2.0 permite a los usuarios interactuar y colaborar entre sí como creadores de contenido generado por usuarios en una comunidad virtual, a diferencia de sitios web estáticos donde los usuarios se limitan a la observación pasiva de los contenidos que se han creado para ellos.

ORDENADOR: PROBLEMAS COMPLEJOS, DECISIONES SIMPLES

Un ordenador hace mucho más que ordenar. Es una palabra prestada del francés ordinateur, que es la traducción del original inglés computer. Con ese nombre se designaba a los especialistas en hacer cálculos numéricos y en el siglo XIX comenzó a aplicarse a máquinas, que calculaban cada vez más rápido.

En el siglo XX, cuando los engranajes de las máquinas se sustituyeron por componentes electrónicos, se generalizó el uso de la palabra <<ordenador>>. Estos componentes tenían el inconveniente de que se construían para resolver un problema determinado y había que cambiarlos sí se querían usar para otro fin.

Hasta que en 1936 un estudiante inglés, Alan Turing, es considerado uno de los padres de la ciencia de la computación siendo el precursor de la informática moderna. Proporcionó una influyente formalización de los conceptos de algoritmo y computación: la máquina de Turing. Pensó en una computadora que lograría resolver todo tipo de problemas que pudiera traducirse en términos matemáticos y luego reducirse a una cadena de operaciones lógicas con números binarios en las que solo cabían dos decisiones: verdadero o falso. La idea era reducir todo (cifras, letras, imágenes, sonidos) a ristras de unos y ceros y usar una receta, un programa, para resolver los problemas en pasos muy simples.

Había nacido el ordenador digital, pero era una máquina imaginaria. Tras la Segunda Guerra Mundial, en la que ayudó a descifrar el código Enigma de los mensajes en clave de los nazis, Turing creó uno de los primeros ordenadores como los actuales, digital y también programable: podía usarse para muchas cosas con solo cambiar el programa.

Evolución permanente

La máquina de Turing prontó quedó obsoleta, como pasa ahora. Los ordenadores han seguido duplicando su potencia de cálculo cada año y medio, como predijo Gordon Moore en 1965.

Por muy rápido que sea ahora un PC, para usarlo todavía hay que esperar cerca de un minuto mientras arranca tras unas comprobaciones, empieza a copiar el sistema operativo (el programa imprescindible para funcionar) desde el disco dura hasta la memoria RAM. Cada vez que se enciende el ordenador hay que repetir el proceso, pues la memoria se borra al apagar y cada casilla de información o bit (que puede valer de 0 a 1) marca 0.

Turing solo llegó a ver los primeros cerebros electrónicos. Él creía que los ordenadores sí podrían llegar a pensar y, con el programa adecuado, hacer cosas como chatear sin que pudiéramos distinguir si nuestro interlocutor era una persona o un ordenador. Nadie ha conseguido crear todavía un programa que supere una prueba denominada test de turing. Alan Turing es, entre otras cosas, el precursor de la computación. Su famosa Máquina de Turing es un compuesto abstracto o teórico que simula el comportamiento de cualquier tipo de ordenador. Alan Turing fue el consolidador formal del concepto de algoritmo, que es la base del funcionamiento de todos los ordenadores actuales. Turing también dedicó gran parte de su ingenio en desarrollar teorías acerca de la inteligencia artificial (uno de sus logros más importantes fue el diseño del Test de Turing, que permite determinar si una entidad es inteligente o no).

Con 40 años Turing había abierto el campo de la Inteligencia Artificial, pero

en la cumbre de su carrera científica fue condenado por mantener

relaciones homosexuales. Para evitar la cárcel, aceptó someterse a un

tratamiento hormonal. Dos años más tarde murió, tras dar el primer

bocado a una manzana envenenada con cianuro. Mucho después, una marca de ordenadores adoptó como símbolo una manzana arco iris como homenaje.

EJERCICIO PÁGINA 236

Chatea con un ordenador

Un bot de charla (o chabot) es un programa que está diseñado para similar una conversación inteligente con humanos. Pero ninguno lo hace tan bien como para superar el test de turing.

- Busca bots de charla en Internet, prueba diferentes modelos. A continuación describe sus tácticas para hacerse pasar por una persona y explica por qué nota que lo es.

Software, hardware y firmware: trabajo en cadena.

El Software de los ordenadores es el manual de instrucciones que permite convertir un problema, una tarea, en una gran cantidad de operaciones matemáticas sencillas, que se calculan a gran velocidad.

Los programas y juegos están en el primer eslabón de esa cadena: convierten nuestras acciones y deseos en tareas aún muy complejas que realiza el sistema operativo. Por ejemplo, si pulsas el botón <<Nuevo documento>> de su procesador de textos, el programa le pide al sistema que abra una ventana y este le pasa la orden a sus bibliotecas de funciones.

Algunos programas necesitan funciones que no tiene el sistema (por ejemplo, la capacidad para ver películas en formato DivX) y se las añaden instalando más bibliotecas o unos módulos llamados plug-ins.

Las funciones del sistema o las añadidas convierten cada tarea en una larguísima serie de instrucciones que son especificas para el hardware:se refiere a todas las partes tangibles de un sistema informático; sus componentes son: eléctricos, electrónicos, electromecánicos y mecánicos, el microprocesador, la memoria RAM, el disco duro, la tarjeta gráfica, el grabador de DVD, etcétera.

El sistema operativo se relaciona con los dispositivos anteriores a través de otro software, los controladores.

Esta estructura encadenada hace que un programa hace que un programa pueda ejecutarse sin problemas en muchos ordenadores distintos, pero combatibles.

El software aparece como algo casi independiente del hardware. La cadena de instrucciones sigue dentro de los dispositivos (internos) y periféricos (accesorios) del ordenador. Cada uno de estos contiene un pequeño ordenador que controla sus motores y circuitos electrónicos mediante otro programa tan ligado a los componentes electrónicos que no se considera software, sino firmware. (El firmware es un bloque de instrucciones de máquina para propósitos específicos, grabado en una memoria, normalmente de lectura / escritura que establece la lógica de más bajo nivel que controla los circuitos electrónicos de un dispositivo de cualquier tipo) .

Algunas prestaciones del periférico se pueden mejorar si se cambia el firmware. Por ejemplo, al actualizar el firmware de un iPod podemos corregirle fallos de funcionamiento o enseñarle nuevas funciones, como leer los más recientes formatos de música o vídeo.

Una máquina para sustituir al doctor House

El televisivo doctor House es un ejemplo de cómo la intuición, la experiencia o bien una corazonada ayudan a los humanos a la hora de tomar decisiones complicadas.

Un ordenador no cuenta con este factor humano, pero en los hospitales ya comienzan a usarlos para decidir el mejor tratamiento para algunos pacientes, ya que gracias a programas de minería de datos, que analizan múltiples variables y sus relaciones, sus relaciones son muy acertadas.

ALMACENAMIENTO DIGITAL DE LA INFORMACIÓN

Bits y bites, bocaditos de información

La forma más cómoda de llevar información es el llavero de memoria (pincho USB, lápiz de memoria o pen drive).

En su interior hay un chip, formado por multitud de celdas que funcionan como diminutos interruptores con dos posiciones: on y off, que equivalen a 0 y 1 en sistema binario. Así, cada casilla almacena bit (Binary digiT) de memoria. Un bit es la cantidad mínima de información, pero es muy raro verlos en solitario.

En nuestros ordenadores, los bits están agrupados en octetos llamados bytes (1 byte=8bits=un bocadito, en inglés).

¿Por qué ocho? El caso es que con los 8 bits de un byte pueden representarse 256 valores: del 00000000 al 11111111 en sistema binario, que es lo mismo que decir del 0 al 255 en números decimales.

Y con estos 256 caracteres diferentes, los occidentales tenemos más que suficiente para escribir cualquier cosa.

El código ASCII se usa para almacenar documentos de texto en la memoria y en los discos.

El código ASCII traduce en un solo carácter (letra, número, símbolo) cada uno de los 256 posibles valores binarios de un byte.

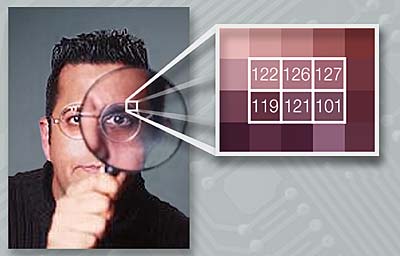

Imagen digital, el puntillismo informática

Los ordenadores, teléfonos móviles, navegadores, GPS, iPod, etc., son artistas del puntillismo. En sus pantallas, una imagen es un cuadro de diminutos puntos llamados píxeles. Un píxel o pixel, en plural píxeleses,es la menor unidad homogénea en color que forma parte de una imagen digital, ya sea esta una fotografía, un fotograma de vídeo o un gráfico.

El realismo de la imagen depende de la cantidad de información usada para colorear cada píxel.

Lo mínimo es 1 bit por píxel: dos colores, blanco y negro. Pero lo que tradicionalmente llamamos imagen en blanco y negro es en realidad una escala de grises.

Con 1 byte podemos representar 256 tonos diferentes para cada píxel y eso es suficiente para visualizar una fotografía, aunque se diga que entre el blanco y el negro hay una infinita gama de grises.

Si queremos ver la foto en color necesitamos 3 bytes por píxel.

Comprensión, quedarse con lo imprescindible

Para visualizar y mandar fotos por Internet se suelen guardar en JPG, un formato que comprime el tamaño del archivo entre 10 y 20 veces con una pérdida de calidad aceptable, usando un complejo algoritmo.

También se pueden perder datos al comprimir música en MP3 o películas en DivX:

El DIVX es un nuevo sistema de video del tipo llamado pay-per-view (pago por vision), utiliza discos especiales del tipo de los compact disc y requiere un lector especial y una conexion telefonica. Este sistema se comercializara en principio en USA hacia el verano del año 1998.

Debido al tipo de cifrado DES de la información en el disco, esta tecnología posiblemente no este permitida fuera de los USA (afortunadamente para nosotros en Europa)

¿En qué consiste? El usuario compra los derechos para ver una película de video por un tiempo limitado, se compra una película grabada en un compact disc en un formato cifrado y con la compra tiene un periodo de tiempo de dos días para verla desde el momento en que la reproduce por primera vez en su lector divx sea el día siguiente de la compra o al cabo de unos meses, durante este periodo de tiempo, los discos se pueden reproducir las veces que se desee, parar la imagen, avanzar, etc, estos formatos descartan información redundante.

En cambio, para documentos de texto se usan formatos de comprensión sin pérdida de datos, como el ZIP, pues no interesa que al descomprimir falten letras o palabras. Zip es un concepto que se utiliza en la informática para nombrar a ciertos formatos de almacenamiento, ya sean físicos o virtuales. A nivel de software, el zip se utiliza para la comprensión de datos (documentos de texto, imágenes, programas, etc.) sin pérdida de calidad.

Digitalización

Digitalizar sonido o vídeo tiene una gran ventaja: cada copia es un clon idéntico al original, mientras que con cada copia sucesiva de una cinta analógica se pierde calidad.

Para guardar un texto en un ordenador basta con traducir letras a bytes el código ASCII.

No es tan fácil convertir el sonido (analógico) en una ristra digital de unos y ceros que un ordenador pueda almacenar y procesar. La señal analógica es una onda continua, que vemos como una curva. Al convertirla a digital lo que hacemos es tratar de reproducir esa curva con barras verticales que representan muestras de audio tomadas cada cierto tiempo.

Comprensión

Pero esos archivos son muy grandes . Así, en un CD de 700 megabytes caben 80 minutos de música. Descargar una sola canción con un módem de 56 Kbps llevaba horas. Había que reducir el tamaño del archivo sin perder calidad.

La solución fue el MP3, un formato comprimido de música digital que descarta los sonidos que el oído humano medio no puede recibir y los que no se oyen cuando suenan al mismo tiempo que otros.

El algoritmo de comprensión MP3 consigue que se reduzca 11 veces al tamaño del archivo y mantiene casi la misma calidad de sonido de un CD.

Además, cada archivo MP3 contiene unos bytes extra en los que se almacena información como el título de la canción, autor, año de grabación, etcétera.

P2P.Redes de intercambio de archivos

Con el invento del formato MP3 los internautas empezaron a compartir canciones. ¿Cómo poder encontrarías y descargarlas a buena velocidad?

En 1998 un estudiante universitario de 18 años creó Napster, un programa de intercambio de archivos basado en la tecnología P2P (peer-to-peer), cuyo significado es <<comunicación entre iguales>>.

En Internet los ordenadores se comunican por lo general a través de servidores centrales: para compartir un archivo, un usuario tendría que subirlo a un servidor y otro descargarlo de allí. Con el P2P pueden enviarse los archivos directamente.

Esto abrió la vía de compartir a escala global, incluso material protegido con copyright. También abrió una batalla legal y las discográficas consiguieron que los jueces cerraran Napster, fue un programa que daba servicio de intercambio de archivos en P2P, permitiendo descargar música, imágenes, documentos, videos y otros archivos.Su popularidad y la controversia generada alrededor de éste, lo convirtieron en un verdadero hito de la historia de internet y la computación.

Pero surgieron nuevas redes P2P como eDonkey, BitTorrent o Ares, que cada vez hacen más fácil compartir música, software y vídeos.

- eDonkey : Red de ficheros compartidos que permite a los usuarios acceder a los recursos locales intercambiando programas música y películas.

- BitTorrent : BitTorrent es un protocolo y programa creados para el intercambio de archivos entre iguales (peer to peer o P2P), creados por Bram Cohen, programador estadounidense. Específicamente el protocolo fue diseñado en abril de 2001, e implementado y lanzado el 2 de julio de ese año.

BitTorrent permite distribuir grandes cantidades de datos sin que eldistribuidor original tenga que gastar grandes recursos de ancho de banda, hosting o hardware. Cuando los datos son distribuidos usando el protocolo BitTorrent, los receptores pueden enviar inmediatamente los datos a nuevos receptores, reduciendo así el costo y carga de una única fuente individual.

- Ares : Ares es un programa para compartir archivos que trabaja en una red descentralizada (P2P, Point to Point o Punto a Punto), permitiendo la descarga directa de archivos entre los usuarios del programa que forman parte de esa red. El programa Ares permite buscar y descargar cualquier archivo que otras personas pongan a disposición. Se comparten todo tipo de archivos: musica mp3, videos, programas, documentos, etc.

EJERCICIO PÁGINA 241

¿Legal o no legal?

El criterio sobre sí es legal compartir música y películas usando redes P2P varía de un país a otro: España <<Una juez dice en una sentencia que las descargas de música con P2P son legales si no tienen ánimo de lucro>> (01/11/2006).

http://www.20minutos.es/noticia/167999/0/internet/sentencia/p2p/

Francia: <<Sarkozy acuerda con los proveedores cortar internet a los piratas reincidentes>> (23/11/2007)

http://www.adn.es/tecnologia/20071123/NWS-2432-Sarkosy-reincidentes-proveedores-internet-acuerda.HTML

SATÉLITE: CIENCIA FICCIÓN HECHA REALIDAD

Mientras servía en la Royal Air Force británica durante la Segunda Guerra Mundial. Arthur C. Clarke empezó a vender sus historias de ciencia ficción a varias revistas.

Quizá por eso nadie se lo tomó muy en serio cuando, recién terminada la guerra, en octubre de 1945, publicó un artículo científico titulado <<Repetidores extraterrestres>>. En este artículo Clarke proponía el uso de satélites como repetidores para que las emisoras de televisión pudieran tener una cobertura mundial. Entonces solo existían los satélites naturales: las lunas que tienen todos los planetas del Sistema Solar menos Mercurio y Venus.

En 1957 los soviéticos pusieron en órbita el primer satélite artificial, el Sputnik I, inaugurando la carrera espacial entre Rusia y Estados Unidos.

Un satélite tiene que estar a una altura de 35786 Km para mantenerse en esa órbita geoestacionaria y girar con la misma velocidad con la que rota la Tierra.

El 20 de julio de 169, unos 500 millones de personas de todo el mundo siguieron en directo la retransmisión de los primeros pasos de un ser humano sobre la Luna, gracias a que pocos días antes se había completado el primer sistema global de comunicaciones por satélite.

Se cumplía el sueño de Arthur C. Clarke, que ya era un escritor famoso. Un año antes se había estrenado 2001: Una odisea en el espacio, basada en una novela que escribió a la vez que Stanley Kubrick la película.

En homenaje a su predicción sobre las telecomunicaciones hoy se conoce como <<órbita Clarke>> la órbita geoestacionaria, en la que también circulan satélites meteorológicos, de comunicaciones y militares, pero no de localización por GPS.

La Tierra vista desde el espacio

El programa Google Earth combina imágenes de la Tierra obtenidas desde satélites con fotografías aéreas y con representaciones en 3D de datos de información geográfica que aparecen en diferentes capas: localidades, carreteras, lugares de interés turístico, edificios, fotos, etcétera.

Está última tecnología, de los Sistemas de Información Geográfica (GIS), representa bases de datos sobre mapas digitales cuyo análisis tiene múltiples aplicaciones: conocer la mejor ubicación de un colegio u hospital, decidir que trazados de carreteras son los de menor impacto ambiental, usarlo en marketing, investigaciones científicas y criminológicas, etcétera.

Un ejemplo de estos sistemas es: Sistema de Información Geográfica de Parcelas Agrícolas. Este sistema se puede encontrar en: www.sigpac.mapa.es/fega/visor/

GPS: LA BRÚJULA DEL SIGLO XXI

El sistema de Posicionamiento Global (GPS) nació en 1995 como una red de satélites de apoyo a la navegación marítima que permite conocer en todo momento y en cualquier condición meteorológica las tres coordenadas (latitud, longitud y altitud) que localizan un punto sobre la Tierra.

A lo largo de la historia, la necesidad de conocer la posición de un barco en alta mar llevó a la mejora de los conocimientos astronómicos y al desarrollo de relojes precisos e instrumentos de negación como el astrolabio.

El GPS resolvió este problema de forma definitiva usando una versión sofisticada de la técnica de triangulación, empleada desde el siglo XVIII para la medida precisa de los terrenos, la confección de mapas y los estudios topográficos.

Funciones del GPS

En los navegadores para vehículos, en lugar de las tres coordenadas GPS, la localización aparece como un indicador sobre un mapa de carreteras.

En este mapa pueden aparecer además la situación de gasolineras, zonas de velocidad reducida, radares, etcétera. Estos puntos de interés (PDI) están grabados en una base de datos que se pueden actualizar por Internet.

Además, el navegador calcula con un programa la mejor ruta entre la posición actual y al destino.

¿Puedes localizarme a través del GPS?

Es imposible localizar a nadie solo a través de un navegador, ya que, solo recibe la señal. Los sistemas de localización de vehículos o mercancías añaden un módulo emisor que transmite las coordenadas calculadas por el GPS. Las coordenadas se envían mediante el sistema de transmisión de datos GPRS, cuyas siglas invitan a la confusión. A prueba de atascos

Para evitar atascos y errores al calcular las rutas, además de actualizar los mapas con frecuencia, es necesaria que el navegador reciba información de las incidencias por el Canal de Mensajes de Tráfico (TMC), por alguna emisora de radio o por teléfono móvil. Algunos modelos permiten a los usuarios hacer sus propias modificaciones (corregir errores en mapas, añadir tramos cortados...) y compartirlas con el resto a través de Internet. Un sistema que falla a propósito

Conocer la ubicación exacta tiene gran utilidad militar. Por eso, el Departamento de Defensa de Estados Unidos, que desarrolló y gestiona este sistema, introdujo un error controlado de unos pocos metros de la señal pública del GPS.

Esto no es un problema para los navegadores de los coches. Los satélites emiten además una señal codificada de mayor precisión que pueden descifrar los dispositivos autorizados. Funcionamiento del GPS Sistema de satélites. Discurren por seis órbitas con distinta inclinación sobre el plano ecuatorial, con cuatro satélites en cada órbita. Así cualquier punto de la Tierra tiene de forma permanente a la vista suficientes satélites para determinar su posición. Receptor. El navegador recibe la posición de cada uno de los satélites a la vista y calcula la distancia que hay hasta ellos, midiendo el tiempo que tarda en llegarle la señal que emiten. Para ellos es imprescindible que los relojes de los satélites y del receptor estén perfectamente sincronizados. Las señales viajan a la velocidad de la luz, y un desfase de apenas una milésima de segundo representa un error de varios Kilómetros. Estaciones terrestres. Controlan las órbitas de los satélites y se encarga de su mantenimiento. Triángulo esférico. La distancia a un satélite localiza al receptor en la superficie de una esfera centrada en el satélite y con un radio igual a esa distancia (1y2). La intersección entre las dos esferas de dos satélites determina una línea (3y4). Si la cruzamos con la esfera de un tercero solo quedan dos puntos de intersección (5). Uno estará sobre la superficie terrestre y el otro no, por lo que queda descartado (6).

TELÉFONO MÓVIL: CUESTIONES CELULARES

De ser pesadas maletas solo al alcance de los yuppies en los años ochenta, los móviles han pasado a ser pequeños objetos que caben en cualquier bolsillo.

Ya hay más teléfonos móviles que fijos, en muchos países de Europa hay más móviles que personas, y hoy en día en África es el continente con mayor crecimiento en telefonía móvil. En conjunto, sus usuarios son muchos más que los internautas: casi 3000 millones en todo el planeta.

En América, donde no son tan populares como en Europa y Asia, los móviles se llaman <<celulares>>. El nombre viene de la tecnología usada en estos aparatos, que en realidad son radioteléfonos muy sofisticados.

Los primeros teléfonos portátiles se instalaban en los coches y se comunicaban con un potente transmisor central que cubría un radio de hasta 70 Kilómetros alrededor de cada gran ciudad. Para poder hablar con la central los teléfonos debían emitir con mucha potencia, la suficiente como para recorrer esos 70 Kilómetros, de ahí, su tamaño y la necesidad de una gran batería.

Más antenas, menos radiaciones

Entonces llegó la estrategia celular: dividir la zona de cobertura en células mucho más pequeñas, en cuyo centro se instala una antena. Las células de la red de telefonía están coordinadas de manera que la conexión no se corta a pasar de una a otra y el móvil cambia solo de canal.

Por temor a posibles efectos dañinos de las ondas de telefonía móvil sobre la salud, mucha gente rechaza la instalación de antenas cerca de su casa.

Aunque resulte paradójico, si queremos reducir la potencia de emisión de los móviles, se tiene que hacer lo contrario,: instalar muchas antenas, para que siempre tengamos una cerca.

De esta manera, siguiendo esa estrategia celular que requería menos potencia, los teléfonos portátiles pudieron evolucionar hasta convertirse en móviles.

¿Ondas bajo sospecha?

Hasta ahora no hay ninguna evidencia científica de que las radiaciones empleadas en la telefonía móvil pueden causar ninguna enfermedad.

Estas ondas no son muy diferentes a las de la radio. Tienen algo más de energía, se las considera microondas (aunque son menos intensas que la de los hornos) y están en una zona del espectro electromagnético muy por debajo de los rayos de la luz visible.

Por encima de la zona visible, los rayos ultravioleta de alta frecuencia, los rayos gamma y los rayos X pueden provocar problemas de salud, pues son tan energéticos que son capaces de romper moléculas como el ADN de las células de nuestro cuerpo, y desencadenar el cáncer.

Sin embargo, los microondas que originan los móviles son incapaces de romper enlaces entre átomos; por eso la ciencia actual no entiende cómo estas ondas podrían llegar a provocar un tumor.

De momento el único riesgo probado para la salud es usar los móviles mientras se conduce: esa distracción multiplica por cuatro la posibilidad de un accidente de tráfico. Por lo demás, los experimentos que sí relacionan el uso del móvil con el cáncer, la pérdida de memoria o el dolor de cabeza no han dado los mismos resultados al repetirse: no pueden darse por válidos.

COMUNICACIONES SEGURAS: CLAVE PÚBLICA Y PRIVACIDAD

Todo el alcance de un clic: compras, operaciones bancarias, trámites administrativos, intercambio de información o conversaciones en tiempo real.

Cada vez que realizamos una de estas operaciones enviamos al ciberespacio información privada. Y lo hacemos con seguridad gracias a la criptografía de clave pública, que entra en escena cuando nos conectamos a Internet, usamos un cajero automático o compramos un programa de televisión por pay per view.

Es un invento que está en nuestra rutina diaria, pero la mayoría de las veces no somos conscientes de ello.

Desde que hace dos mil años se emplease por vez primera la criptografía, su principal limitación había sido la distribución de la clave, la <<llave>> que permite al emisor sellar el mensaje (cifrarlo) y al receptor abrirlo (descifrarlo).

Esto exige que ambas partes busquen un sistema muy seguro para realizar el intercambio. De ahí la típica escena de película con un individuo trajeado y esposado a un maletín, que pasó a al historia con el descubrimiento de la criptografía de clave pública en 1976.

Con el sistema de clave pública ya no es necesario intercambiar la clave secreta. Cada usuario tiene una clave pública (que es como un candado abierto) y otra privada (la llave de ese candado).

Si Alicia quiere mandarle una carta confidencial a Benito, primero le pide a él que le mande un candado abierto. Cuando Alicia lo recibe, lo usa para cerrar una caja que lleva dentro la carta y le manda la caja por correo a Benito. Él es el único que puede abrirla, pues es el único que puede abrirla, pues es el único que tiene la llave (clave privada) que abre su candado (clave pública).

Ciencias de lo oculto

En sentido estricto la criptografía es la ciencia que se encarga de la ocultación su nombre deriva del griego Kryptos, que significa <<oculto>> del significado de un mensaje para mantenerlo en secreto. Este procedimiento se conoce como codificación y se realiza aplicando un protocolo especifico (un sistema de codificación) acordado de antemano por el emisor y destinatario del mensaje y que solo ambos deben conocer.

Proteger el mensaje como ente físico es tarea de otra ciencia secreta: la Esteganografía: Técnica que consiste en ocultar un mensaje secreto dentro de otro más largo, de forma que terceras personas no puedan descubrirlo.

Históricamente la esteganografía es una técnica muy antigua que data del año 474 a.c. y que goza de trascendental importancia en la actualidad. Durante la Segunda Guerra Mundial se desarrollaron diversas técnicas para mandar información oculta.

Comercio electrónico y protección de datos

Aunque Internet no tenga dueño, el ciberespacio no puede ser una ciudad sin ley. En España hay dos normas que regulan los derechos y deberes de los internautas:

- Ley de Servicios de la Sociedad de la Información (LSSI), de 2002, que se aplica al comercio electrónico, la publicidad y cualquier servicio por Internet que dé beneficios económicos: www.Issi.es

- Ley Orgánica de Protección de Datos de Carácter Personal (LOPD), de 1999, que se aplica a las empresas y entidades públicas que dispongan de datos personales de los ciudadanos. La Agencia Española de Protección de Datos vela por su cumplimiento: www.agpd.es/index.php. En su web hay una sección de preguntas frecuentes y una revista de prensa con noticias sobre protección de datos.

Si pasamos de la analogía postal a Internet, una de las aplicaciones de la criptografía de clave pública es el cifrado de datos para ocultar información privada. Otra es revelar la identidad del emisor de un mensaje. Esto se consigue con las firmas digitales que se almacenan en el nuevo DNI electrónico: quien manda un documento con una firma hecha con su clave privada se asegura de que cualquier destinatario que conozca su clave pública pueda comprobar que el documento es auténtico, que la firma no ha sido falsificada.

* El cifrado de datos es el tratamiento de un conjunto de datos, contenidos o no en un paquete, a fin de impedir que nadie excepto el destinatario de los mismos pueda leerlos. Hay muchos tipos de cifrado de datos, que constituyen la base de la seguridad de la red.

Firmas digitales:

Direcciones seguras

Las direcciones que empiezan con https y un icono con un candado indican de una web usa un protocolo criptográfico de cifrado de datos que permite comunicaciones seguras.

Nunca envíes datos confidenciales (por ejemplo, el número del DNI o tarjeta de crédito) si no ves unas señales de seguridad.

LA VIDA DIGITAL

Internet, navegador, web, google, blog, Wikipedia, ordenadores, MP3, P2P, satélite, GPS, teléfono móvil y comunicaciones seguras. Una docena de inventos que, entre otros, han cambiado nuestras vidas: cómo nos comunicamos, cómo nos relacionamos, cómo viajamos, cómo estudiamos, cómo trabajamos, y a qué dedicamos el tiempo libre.

Algunos expertos vaticinaban otros cambios: en pocos años los libros y periódicos electrónicos conseguirían desplazar a sus precursores de papel. La prensa escrita no desaparece y lo que ha empezado a restarle ingresos a su negocio no son los medios de comunicación digitales sino un fenómeno que nadie había previsto: las páginas web de anuncios por palabras como craigslist.org.

La versión digital/virtual de productos o servicios que ya existían no siempre tiene más éxito, y en muchos casos conviven ambas versiones.

Bricomanía digital

En los foros especializados de la Red los usuarios comparten sus conocimientos y modifican (<<hackean>>) los dispositivos electrónicos para añadirles funciones que los fabricantes descartaron, o para liberar restricciones de uso. Un ejemplo es hacer que un reproductor de DVD pueda leer discos en cualquier zona. Entre estos <<manitas>>, llamados hackers, solo algunos utilizan su dominio de las nuevas tecnologías con fines maliciosos; son los crackers.

* Hackers : El término hacker, se utiliza para identificar a los que únicamente acceden a un sistema protegido como si se tratara de un reto personal sin intentar causar daños.

* Crackers : El término Cracker tiene varios significados en el area de la informática:

- Persona que viola la seguridad de un sistema informático con fines de beneficio personal o para hacer daño.

- Persona que diseña o programa cracks informáticos, que sirven para modificar el comportamiento o ampliar la funcionalidad del software o hardware original al que se aplican.

El mercadillo global

Otro gran hito del comercio electrónico ha sido el sitio de subastas online eBay.

Ahora los compradores pueden convertirse también en vendedores y tienen acceso desde casa a objetos que proceden en cualquier lugar del mundo: desde artesanía de una remota zona de África hasta aparatos electrónicos que solo se venden en Asia, pasando por ropa de segunda mano. Y todo ello sin que los intermediarios se lleven un gran porcentaje del precio. Es el P2P, pero aplicado al comercio.

El mercado de segunda mano en Internet da salida a ordenadores, teléfonos móviles y otros dispositivos que, al estar en constante evolución, pronto se quedan obsoletos y de otra forma terminarían por añadirse a la basura electrónica.

* Ebay : Compañia de Internet encargada de ebay.com que vende productos y servicios de todo tipo a nivel mundial.

EJERCICIO PÁGINA 252

Kit de navegación privada, cómoda y segura.

Una cookie es un trocito de información que se almacena en el disco duro de tu ordenador cada vez que accedes a determinadas páginas web.

Así, por tus visitas anteriores, esas webs pueden identificarte y mostrarte los contenidos personalizados o los que más interesan. Pero también pueden recoger datos sobre tus hábitos de navegación que preferirías que fueran privado. Si quieres dejar menos huellas en Internet, puedes desactivar las cookies es el menú de preferencias de tu navegador.

Al navegar también es posible que surjan problemas de seguridad (compras on line en webs inseguras, prácticas de phishing que usan cebos para que los usuarios revelen sus datos personales...) y de comodidad (ventanas emergentes, llamadas pop-ups), con anuncios indeseados).

- Investiga esos problemas y elabora una presentación (Power Point o similar) con consejos para poder navegar de forma privada, cómoda y segura).

Ante todo lo más importante para una navegación web segura

es tener un buen antivirus que no quiere decir que sea de pago, instalado y

actualizado.

También se recomienda eliminar los archivos y cookies temporales que almacena el navegador, ya que muchas veces los spyware se guardan en esa dirección y cuando introducimos una contraseña en una página web, se debe tener mucho cuidado, ya que hay webs clonadas que roban las contraseñas de los usuarios.

Es recomendable no dejarse llevar por la publicidad y mensajes que aparecen en las páginas web. Hay muchos navegadores que ayudan a resolver estos problemas, como mozilla firefox y Google Chrome, que son navegadores que muestran las páginas webs con la menor cantidad de publicidad posible, de esta manera el usuario podrá visualizar una web limpia y libre de publicidad basura.

Las páginas que contienen en el inicio de su dirección web

el código https:// son las más confiables para realizar transacciones y compras

en Internet. Cuando se quiera entrar al correo electrónico personal, se debe

introducir el usuario y contraseña de manera discreta y en un sitio web que

garantice seguridad, como Hotmail, Gmail, Yahoo, entre otros.

Finalmente se recomienda cambiar de contraseña

periódicamente y no abrir o ejecutar archivos de correos desconocidos o con

archivos ejecutables (.exe).

EJERCICIO PÁGINA 255

Apadrina un científico

Escoge entre las siguientes una red de ciencia distribuida para unirse a su causa :

a) Instala y prueba el salvapantallas correspondiente.

b) Explica en no más de cicnco pasos cómo funciona esa red , es decir, el proceso que tiene lugar en tu ordenador y en los servicios centrales para repartir y procesar todo ese trabajo.

He elegido la aplicación foldin@home

que estudia el plegamiento de proteínas para curar enfermedades, tras instalar

la aplicación podemos comprobar como se realizan cálculos continuamente.

Folding@home es un

proyecto/aplicación que trata de usar los recursos de los ordenadores de todo

el mundo que quiera apoyar la causa para realizar simulaciones de plegamientos

proteicos que están relacionados con enfermedades.

Esta aplicación se nutre de participantes voluntarios que

con sus ordenadores personales, descargan el programa y al instalarlo,

contribuyen a la investigación con parte de los recursos de su ordenador para

realizar cálculos y simulaciones sobre los plegamientos proteicos.

El cliente de Folding@home

periódicamente se conecta a un servidor para descargar unidades de trabajo y

realizar cálculos con ellos, cuando se terminan los cálculos se vuelve a enviar

los resultados al servidor y vuelta a empezar el mismo proceso.

Los usuarios del programa pueden ser anónimos o

identificarse y ademas pueden consultar estadísticas de lo que han ayudado o

han conseguido con su aportación en la web de folding@home.

EJERCICIO PÁGINA 255

Debate sobre los derechos de autor

El copyright nació en el siglo XVIII para evitar la copia indiscriminada de obras literarias, artísticas y científicas con las imprentas.

La aparición de Internet, una red que ha sido creada para compartir información, ha impulsado nuevos tipos de licencias, por ejemplo, Creative Commons, cuya página web es es.creativecommons.org/

- Investiga sobre las ventajas del copyright y defiéndelo ante un compañero que haya hecho lo mismo con Creative Commons. ¿ Qué opina el resto de la clase ?

Derechos de autor y Copyright:

El derecho de autor consta de varias normas jurídicas que

regulan los derechos morales y patrimoniales que protegen a los autores que

crean un libro, arte, música, ciencia o enseñanzas, haya sido publicada o no.

En Inglaterra se usa la palabra copyright para referirse a

los “derechos de autor” y van dirigidos mas a la obra que al autor.

Es uno de los derechos humanos fundamentales de la

Declaración Universal de los Derechos humanos.

Cuando los derechos patrimoniales de una obra terminan, la

obra pasa a dominio publico, normalmente ocurre tras la muerte del autor que

viene a ser de entre 50 y 70 años, cuando pasan esos años, la obra puede ser

usada libremente.

Creative Commons:

Bienes Comunes Creativos, organización sin ánimo de lucro

que mediante instrumentos jurídicos gratuitos permite usar y compartir

creatividad y conocimiento.

Se trata de una unión de licencias de derechos de autor que

permite al autor compartir su obra con el público general bajo las condiciones

que proponga dicho autor y de una forma fácil y estandarizada, también ofrece

la posibilidad al autor de modificar estas condiciones.

Creative Commons es un apoyo a los derechos de autor, no

viene a sustituir estos mismos.

EJERCICIO PÁGINA 255

Encuesta sobre el pirateo

La noticia de que las copias ilegales de Spiderman 3 circulaban por las calles de Beijing antes del estreno oficial de la película en mayo de 2007, puso de manifiesto la efectividad de las redes de pirateo.

El porcentaje de software ilegal a nivel mundial ha crecido en los últimos años hasta situarse en el 35% en 2006. En España esa cifra es aún mayor, un 46%.

- Realiza una encuesta entre tus compañeros de clase y descubre cuáles son vuestros porcentajes.

52 % Piratean Películas.

57 % Piratean Música.

09 % Piratean Libros.

24 % Piratean Software.

31 % Piratean Series de TV.

29 % Piratean Juegos.

Ver la película " 2001: Una Odisea del Espacio" y realizar un comentario sobre la misma.

2001 Una odisea en el espacio (1968)

La película está escrita y dirigida por el célebre director

Stanley Kubrick, es del genero ciencia ficción y trata sobre la evolución, los

viajes espaciales, las comunicaciones y la búsqueda de la vida extraterrestre.

Comienza con una especie de prologo en la que se ve como se

alinean en el espacio la Tierra, la Luna y el Sol y a continuación se divide

claramente en cuatro bloques o episodios:

Aparecen en una tierra árida una “tribu de primates”

conviviendo y se ve como un leopardo asesina a uno de estos, después se ve como

aparece otra tribu de primates y se enfrenta a la original a base de gritos,

sin agresiones físicas por el control de la charca en la que viven.

Cambia la imagen y aparecen los primates originales

durmiendo en cuevas por miedo a la oscuridad y cuando uno de ellos despierta se

encuentra una especie de monolito, despierta al resto de la tribu y comienzan a

adorar el objeto aparecido e incluso a tocarlo.

Justo después del contacto con el monolito uno de los

primates coge por primera vez un hueso y descubre como usarlo de diferentes

formas entre ellas, para derrotar al jefe de la otra tribu de primates, o matar

animales y comenzar a alimentarse de ellos.

Dr. Heywood Floyd viaja hasta una estación espacial para

desde ahí ser enviado a la Luna en una investigación secreta, mientras está en

la estación espacial realiza una videoconferencia con su hija y mantiene una

conversación con antiguos compañeros de diferentes nacionalidades.

Cuando aterriza en la Luna es cuando se entera del verdadero

objetivo de la misión, investigar un monolito de las mismas características del

que salio en el episodio anterior que ha sido detectado por la emisión de unas

ondas muy potentes, cuando va con su equipo de investigación y se acercan al

monolito, al tocarlo este emite un pitido que aturde a todo el equipo de

investigación.

Misión a Júpiter

Un equipo de investigación compuesta por cinco personas en

estado de hibernación, dos personas conscientes y un ordenador con inteligencia

artificial llamado Hal 9000 a bordo de una nave espacial se dirige hacia una

Luna de Júpiter en una misión.

Los dos científicos que no están hibernados realizan labores

de mantenimiento y comunican periódicamente a la base el estado de la misión

ademas de entretenerse (Ajedrez, Tv, videoconferencias) mientras se acercan al

destino además de relacionarse con Hal 9000 que es capaz de comunicarse con

ellos hablando.

Cuando están cerca de Júpiter Hal 9000 habla con uno de los

científicos y le muestra su inquietud acerca del objetivo de la misión, al

negarle el científico esta inquietud, el ordenador “detecta” un fallo inminente

en una de las piezas de la nave, tienen que salir a reemplazarla, más tarde

analizan la pieza reemplazada y no encuentran fallo.

Los científicos comienzan a desconfiar de Hal 9000 y planean

desconectarlo, pero este los descubre y les indica que vuelvan a poner la pieza

averiada para descubrir realmente el fallo, al salir uno de los científicos a

realizar la labor, el ordenador sabotea la misión y mata al científico además

de los otros compañeros que estaban hibernando, quedando solo un superviviente

que sale a rescatar el cuerpo del científico que estaba en el espacio.

Cuando quiere volver al interior de la nave Hal 9000 no lo

deja asique tiene que entrar manualmente y arriesgando su vida, cuando logra

entrar se dirige a desconectar el ordenador mientras este pide clemencia y va

perdiendo funcionalidad.

Cuando desactiva completamente a Hal 9000, se activa un

video con el verdadero significado de la misión, investigar un monolito

detectado que se cree que tiene 4 millones de años de antigüedad.

Júpiter

y más allá del infinito

El científico superviviente ha llegado a Júpiter y cuando se

acerca al monolito que orbita en una de sus lunas, este emite se alinea con los

astros y el científico comienza a tener alucinaciones psicodelicas, más tarde

despierta en una pequeña nave decorada con mobiliario contemporáneo y envejecido

por el efecto de la exposición al monolito, vá viéndose a si mismo reflejado

cada vez mas viejo hasta que de repente aparece el monolito y el científico se

convierte en una especie de feto que asciende hasta el espacio

A mi parecer la película representa la evolución de la

consciencia al ponerse en contacto con el monolito de origen extraterrestre,

debido a que les pasa a los primates, a una inteligencia artificial que no

había fallado nunca e incluso al hombre que llega a cambiarlo de forma o

revolucionarlo.

Son increibles las referencias a la tecnología que se

encuentran en la cinta debido al año en la que se estreno:

- Detección de voz.

- Videoconferencias.

- Hibernacion.

- Tablets.

.jpg)